Neue Hardware braucht der Keller

Lange verrichteten unsere beiden Server im Keller mehr oder weniger leise ihre Dienste. Doch mit den steigenden

Lange verrichteten unsere beiden Server im Keller mehr oder weniger leise ihre Dienste. Doch mit den steigenden

Anforderungen konnten sie leider nicht Schritt halten. Daher musste ein neues System her.

So war es bisher

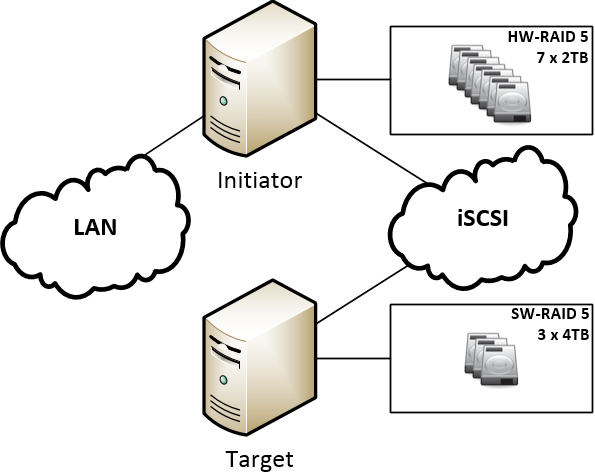

Bisher wurden im Keller 2 verschiedene Server betrieben, zum Einen als Network Attached Storage-Server, welcher nebenbei ein paar virtuelle Maschinen betrieb und zum Anderen eine „SAN„, welche mit OpenMediaVault realisiert wurde. Grafisch sah das Ganze so aus:

In der NAS wurden 7 x 2TB Samsung HD204UI eingesetzt, welche durch ein RAID 5 (Hardware-RAID-Controller Promise FastTrack EX8350) 12 TB ergaben. Zudem wurde via iSCSI die von der SAN bereitgestellten 8TB (3 x 4TB WD RED, Software-RAID) eingebunden. Im Endeffekt standen also 20TB Kapazität bei zwei laufenden Geräten mit insgesamt 10 Festplatten zur Verfügung. Neben den Betriebskosten bestand zudem das Problem, dass die CPU (AMD Athlon x2) der NAS der Bedienung der virtuellen Maschinen nicht mehr hinterher kam und der Arbeitsspeicher von 8GB auch so langsam seinen oberen Füllstand erreichte.

So sollte es werden

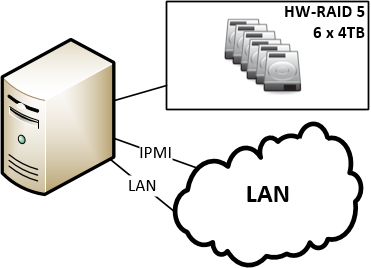

Wir entschieden uns, uns von den 2TB-Festplatten zu verabschieden und mit drei weiteren 4TB-Platten ein neues System aufzubauen. Für die Hardware haben wir uns zu folgenden Komponenten entschieden:

| Typ | Bezeichnung |

| Mainboard | Supermicro X9SCM-F (Infos) |

| Prozessor | Intel Xeon E3-1230 v2 (Ivy) |

| Arbeitsspeicher | 2 x Kingston DDR3 8GB ECC 1333 MHz |

| RAID-Controller | IBM ServeRAID M5014 (Infos) |

| Festplatten | (bisher 6 x) Western Digital RED 4TB (Infos) |

| Gehäuse | Chenbro RM31408 (Infos) |

| Netzteil | 3U 3fach redundant Emacs |

Zukünftig soll es, grafisch gesehen, dann so aussehen:

|

Zudem wollten wir als Betriebssystem auf Windows Server 2012 R2 setzen, nicht zuletzt aufgrund von kürzlich neu gesammelten Erfahrungen und des Erreichens der ersten Microsoft-Zertifizierungsstufe. |

So haben wir es umgesetzt

Umbau 3HE-Gehäuse

Aus dem vorhandenen 3HE-Gehäuse bauten wir die alte Hardware aus. Im Einzelnen wurden das Mainboard mit Netzwerk- und RAID-Controller, die alten 2TB Platten sowie die 2,5″ Boot-Festplatte entfernt. Anschließend installierten wir das neue Supermicro-Board und befestigten den beim Prozessor mitgelieferten boxed-Lüfter. Nachdem auch der RAID-Controller eingebaut war, wurden sämtliche Kabel möglichst sauber verlegt, damit der Luftstrom ungehindert das Gehäuse passieren kann. Anschließend verschraubten wir die neuen Festplatten in die Laufwerksschubladen und setzten diese anschließend in das Gehäuse.

Der erste Start

Nachdem die nötigsten Kabel angeschlossen wurden, wagten wir den Versuch den Power-Taster zu tätigen. Es geschah, was bisher noch bei keiner Arbeit an einer Hardware geschehen sollte: Direkt beim ersten Start erschien eine Ausgabe auf dem Monitor. Selbst der Prozessor und der verbaute Arbeitsspeicher wurden korrekt erkannt so dass der Server nachdem BIOS sogleich versuchte, von der installierten SSD zu booten. Also starteten wir den Rechner neu und passten ein paar wenige Einstellungen im BIOS an. Ein Blick ins Log des DHCP-Servers verriet, dass das IPMI auch sofort versuchte, ein Lease zu erhalten. Nachdem wir also den DHCP-Server mit der MAC-Adresse des IPMIs bekannt machten, öffneten wir an einem Arbeitsrechner die Weboberfläche und suchten uns zur KVMoverIP durch, mit welcher wir den Server fernsteuern können. Zudem wird hier die Möglichkeit geboten, lokal befindliche CD/DVD-Abbilder (ISO) im Server als virtuelles CD/DVD-Laufwerk einzubinden. So war es uns ohne vorheriges brennen einer DVD und ohne dem Anschließen eines lokalen Laufwerkes an den Server möglich, die Installation vom Windows Server 2012 R2 Testimage durchzuführen.

Die Installation

Wie bei der verbauten SSD zu erwarten, war die Installation nach wenigen Minuten abgeschlossen und wir konnten sogleich die grundlegenden Dinge in Windows konfigurieren. Dazu gehörten beispielsweise die Bereitstellung von Updates sowie Kleinigkeiten wie der Rechnername. Jegliche Hardware wurde bereits erkannt und die entsprechenden Treiber ordentlich installiert, für die beiden Intel-Netzwerkkarten installierten wir jedoch die Treiber sowie das Dienstprogramm des Herstellers.

Der erste Rückschlag

Nachdem das Betriebssystem nun installiert und grundlegend konfiguriert war, wollten wir das RAID-Set anlegen und die in der Wohnung verteilten Daten wieder zurückspielen. Dazu starteten wir den Server neu und beobachteten voller Erwartungen den POST. Doch leider blieb eine Meldung des RAID-Controllers oder eine Einladung, durch eine bestimmte Tastenkombination das RAID-BIOS zu betreten aus. Stundenlang stellten wir uns folgende Fragen:

- Meldet sich der RAID-Controller nicht, weil ein UEFI-BIOS präsent ist?

- Erscheint die Möglichkeit, den Controller zu konfigurieren im UEFI-BIOS?

- Wird der Controller zumindest als Hardware unter Windows angezeigt?

- Verfügt der Controller über irgendwelche wild blinkenden LEDs, die auf ein Lebenszeichen hindeuten?

- Wird der Controller mit dem Tool „megarec -adplist“ erkannt?

- Meldet sich der Controller nur, wenn auch Festplatten angeschlossen sind?

- Befindet sich der Controller in einem falschen PCIe-Slot?

- Liegt das Problem am Mainboard und der Controller funktioniert auf dem „alten“ Asus-Board mit dem Athlon X2?

Nachdem nach stundenlangen Suchen und Testen alle Fragen mit einem klaren „Nein“ beantwortet werden konnten, blieb uns nur die Erkenntnis, dass der Controller defekt zu sein scheint.

<ironie>Natürlich kann einem an einem Freitag nichts besseres passieren, wenn die Server-Migration für das gesamte Wochenende angesetzt ist.</ironie>

Nun bleibt uns jedoch nichts anderes übrig, als mit dem Übertragen der Daten zu warten, bis die Ersatzlieferung eintrifft.

Die erweiterte Konfiguration

Auch wenn die Datenpartition jetzt nicht zur Verfügung steht, bedarf es dennoch der weiteren Konfiguration des neuen Servers. So installierten wir weitere benötigte Rollen wie den Speicherdienst (mit NFS-Server), Hyper-V und verschiedene Programme wie

Zudem aktivierten wir die Remotedesktopdienste, um nicht mehr mit der IPMI-Konsole auf den Server zugreifen zu müssen.

Virtuelle Welten

Nachdem die Hyper-V Rolle erfolgreich installiert wurde, konfigurierten wir auch sogleich eine virtuelle Switch, an welche die Gastcomputer angebunden werden sollen. Anschließend wurden zwei virtuelle Rechner eingerichtet, welche mit einem Debian-Linux installiert wurden. Einer der beiden ist gedacht als „Verwaltungsserver“ für alle im Haus befindlichen Himbeeren und soll zudem eine Instanz von openHAB betreiben. Diese wurden so konfiguriert, dass sie beim Starten des Servers automatisch mit gestartet werden und beim Herunterfahren ebenfalls sauber heruntergefahren werden. Zunächst suchten wir eine Möglichkeit, die Integrationsdienste (Gastdienste) von Hyper-V unter Debian zu installieren, bis wir bei einem Test feststellten, dass Debian das Herunterfahren seitens Hyper-V von Haus aus unterstützt. Um so besser.

Nun, nachdem die Konfiguration im Großen und Ganzen abgeschlossen ist, bleibt uns nicht anderes übrig, als auf den neuen RAID-Controller zu warten und zu hoffen, dass dieser dann seine Dienste wie zu erwarten verrichten wird.

16.02.2016 @ 20:44

Es hat sogar so gut geklappt, dass diese Konfiguration bis heute läuft und den Hauptserver des Hauses im Keller darstellt ;)

Ein paar Festplatten sind zum RAID hinzugekommen, aber ansonsten läufts noch wie im Beitrag geplant.

16.02.2016 @ 19:13

Und hat es geklappt?